23년 11월 2일 따끈따끈한 뉴 모델이 나왔습니다! 아래 github에서 보실 수 있습니다! 아래의 글은 아래 github링크에 있는 글을 한글로 번역한 포스팅입니다!

github : https://github.com/huggingface/distil-whisper

GitHub - huggingface/distil-whisper

Contribute to huggingface/distil-whisper development by creating an account on GitHub.

github.com

아쉽게도 한국어에도 특화된 모델은 아니고 영어 ASR버전이라 영어에 특화된 모습입니다. 이전 whisper모델은 한국어 연구자님이 공동 연구를 하여 훈련데이터셋에 한국어도 들어가서 한국어에서도 높은 성능을 보였던 것으로 기억하는데요. Distill-Whisper을 학습한 데이터셋을 한 번 보도록 하겠습니다.

위의 데이터셋은 18,000명이 넘는 화자가 있는 10개 도메인에 걸쳐 총 22,000시간의 pseudo-labeled 지정된 오디오 데이터에 대해 Distil-Whisper를 훈련을 진행했다고 합니다. 어마무시한 데이터셋이네요!

허깅페이스에서 음성인식 데이터셋으로 많이 쓰이는 Common Voice 그리고 음성관련 논문에서 자주 쓰이는 LibriSpeech데이터셋 Fisher데이터셋 등등 제가 활용해보았던 데이터셋들은 이정도 되는 것 같네요. 다 영어 데이터셋 같죠?

한국어에도 성능이 높게 하기 위해선 한국어 데이터셋에 대해 파인튜닝해야할 필요성이 보입니다 :)

Distil-Whisper를 사용해야하는 이유는

1. Whisper의 1% WER이내로 수행하면서 추론 속도가 6배나 더 빠르다고 하네요!

2. 잡음에 대해 굉장히 robust하다고 합니다!

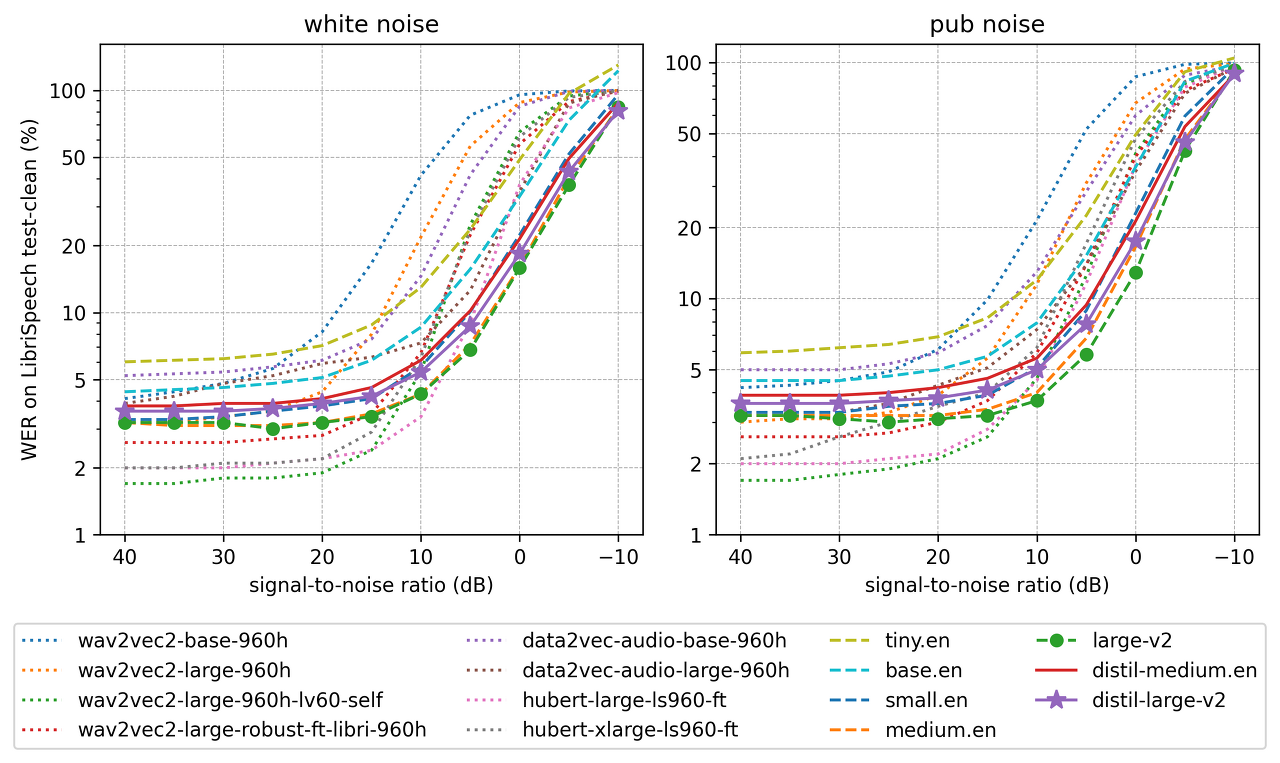

아래가 signal-to-noise ratio는 신호 대 잡음비인데, 숫자가 클수록 잡음이 없는 환경이고 숫자가 작을 수록 잡음이 많이 낀 환경이라고 보시면 됩니다! 잡음이 심한 환경에서 whisper large-v2만큼은 아니지만 비슷한 WER성능을 보이고 있습니다!

WER은 지표가 낮을 수록 정확히 word error율이 낮다고 보시면 됩니다!

3. 환각에 대해 robust하다고 합니다!

Whisper보다 반복되는 5그램 단어 중복(5-Dup.)이 1.3배 적고 삽입 오류율(IER)이 2.1% 더 낮은 것으로 정량화되었습니다.

4. 추론적 디코딩을 위해 설계되었고 합니다!

Distil-Whisper는 Whisper의 보조 모델로 사용될 수 있으며, 수학적으로 Whisper 모델과 동일한 출력을 보장하는 동시에 2배 더 빠른 추론 속도를 제공합니다.

Whisper를 추출하기 위해 전체 인코더 모듈을 복사하고 훈련 중에는 고정한다고 합니다. Whisper의 첫 번째 디코더 레이어와 마지막 디코더 레이어에서 초기화되는 두 개의 디코더 레이어만 복사했다고 합니다. Whisper의 다른 모든 디코더 레이어는 삭제가 된다고 합니다. Whiseper모델에서 어느 부분을 활용했는지는 아래 그림을 통해서 확인 할 수 있습니다

Distil-Whisper는 Knowledge distillation을 목표로 훈련되었다고 합니다! 구체적으로, distilled모델과 Whisper모델 사이의 KL divergence과 pseudo-라벨링된 오디오 데이터의 cross-entropy loss를 최소화되도록 훈련되었다고 합니다!

추가적으로 WER필터를 사용하여 Whisper가 잘못 표기하거나 pseudo-labels을 삭제한다고 하는데, 한국어 맞춤법 교정기로 사용하면 좋겠다는 생각이 드네요.. 그래서 이 기능을 통해 downstream distilled모델의 WER성능을 크게 향상시켰다고 합니다!

추후에 기존에 한글버전으로 whisper만들어놓은게 있는데 distil whisper모델로 교체하면서 실제로 기존 whisper보다 6배 빠른지 실험해서 결과공유하는 포스팅을 올려보도록하겠습니다! huggingface에 모델을 올려놓았다 하니 출시가 되면 얼른 실험하고 포스팅해보겠습니다!

'Audio' 카테고리의 다른 글

| 생성형 AI로 만든 음성 합성(Speech Synthesis)를 체험해볼수있는 곳이 있다구?! (0) | 2023.11.02 |

|---|